- Accueil

- Description des composants de l'ordinateur

Description des composants de l'ordinateur

Je vais vous expliquez tout les composants d’un ordinateur

et surtout à quoi çava servir .

L'alimentation

Bien sur, on aura beau détenir tous les composants ci-dessous, rien ne fonctionnera sans le courant électrique délivré par l'alimentation. Elle transforme et fournit l'énergie nécessaire à la précieuse carte mère, sur laquelle est connectée un bon nombre d'éléments, mais l'alimentation est aussi directement reliée à certains composants tel que le lecteur/graveur de DVD par exemple.

Bien sur, on aura beau détenir tous les composants ci-dessous, rien ne fonctionnera sans le courant électrique délivré par l'alimentation. Elle transforme et fournit l'énergie nécessaire à la précieuse carte mère, sur laquelle est connectée un bon nombre d'éléments, mais l'alimentation est aussi directement reliée à certains composants tel que le lecteur/graveur de DVD par exemple.

La transformation du courant cause une déperdition d'énergie sous forme de chaleur, un système de ventilation est donc installé dans le coffret de l'alimentation et expulse l'air via l'arrière du boîtier de l'ordinateur.

On peut acquérir une alimentation seule bien qu'elle soit très souvent fournie avec le boîtier du PC. Une capacité de 400 watts est généralement suffisante pour les ordinateurs en "configuration bureautique" même si certaines alimentations peuvent atteindre les 1000 watts pour des configurations exceptionnelles.

La carte mére.

La carte mère (motherboard en anglais) est un circuit imprimé servant à interconnecter toutes les composantes d’un micro-ordinateur. Comme elle permet aux différentes parties d’un micro-ordinateur de communiquer entre elles, la carte mère est, d’une certaine façon, le système nerveux du micro-ordinateur.

Une carte mère typique supporte les éléments suivants :

- Un ou plusieurs connecteurs d’alimentation électrique : Par ces connecteurs une alimentation électrique fournit à la carte mère les diverses tensions électriques nécessaires à son fonctionnement ;

- Le support du micro-processeur (souvent appelé socket) : il s’agit d’un réceptacle qui reçoit le micro-processeur et le relie au reste du micro-ordinateur ;

- Les connecteurs de la mémoire vive (memory slot en anglais) au nombre de 2, 3 ou 4 sur les cartes mères communes ;

- Le chipset : Un ou plusieurs circuit électronique, qui gère les transferts de données entre les différentes composantes de l’ordinateur (micro-processeur, mémoire vive, disque dur, etc.) ;

- Une horloge : elle cadence la vitesse d’exécution des instructions du microprocesseur et des périphériques internes ;

- Le CMOS : Une petite mémoire conservant certaines informations importantes (comme la configuration de l’ordinateur, la date et l’heure) même lorsque l’ordinateur n’est pas alimenté en électricité ;

- La pile ou batterie d’accumulateurs du CMOS : Elle fournit l’électricité nécessaire au fonctionnement du circuit ;

- Le BIOS : Un programme enregistré dans une mémoire morte (ROM). Ce programme, spécifique à la carte, gère l’interface de bas niveau entre le micro-processeur et certains périphériques. Il cherche, puis fait exécuter les instructions de la master boot record enregistrées dans une mémoire de masse (disque), lors du démarrage du micro-ordinateur ;

- Le bus système (aussi appelé bus interne ou Front Side Bus (FSB) en anglais) : Il relie le micro-processeur au chipset ;

- Le bus mémoire relie le chipset à la mémoire vive ;

- Le bus d’extension (aussi appelé bus d’entrées/sorties) : Il relie le micro-processeur aux connecteurs d’entrée/sortie et aux connecteurs d’extension ;

- Les connecteurs d’entrée/sortie qui respectent le plus souvent la norme PC 99 : ces connecteurs incluent

- Les ports séries pour la connexion de vieux périphériques,

- Les ports parallèles pour la connexion, entre autres, de vieilles imprimantes,

- Les ports USB (Universal Serial Bus) pour la connexion de périphériques récents,

- Les connecteurs RJ45 pour la connexion à un réseau informatique,

- Les connecteurs VGA pour la connexion d’un moniteur d’ordinateur,

- Les connecteurs IDE ou Serial ATA I ou II pour la connexion de périphériques de stockage comme les disques durs et disques optique;

- Les connecteurs audio pour la connexion d’appareils audio comme des haut-parleurs ou un microphone ;

- Les connecteurs d’extension : ce sont des réceptacles pouvant accueillir des cartes d’extension (ces cartes sont utilisées pour ajouter des fonctionnalités ou augmenter la performance d’un micro-ordinateur, par exemple une carte graphique peut être ajoutée à un ordinateur pour améliorer les performances de l’affichage 3D sur le moniteur). Ces ports sont appelés ports PCI (Peripheral Component Interconnect) et sur des cartes mères plus récentes PCI Express 1× ou 16×.

Avec l’évolution des ordinateurs, de plus en plus de fonctionnalités ont été intégrées à la carte mère, comme des circuits électroniques permettant la gestion de la vidéo (IGP pour Integrated Graphic Processor), du son, des réseaux (10/100 Mbps voire 1 Gbps pour des cartes mères récentes) ou de disques durs évolués, permettant ainsi d’éviter l’adjonction de cartes d’extension fastidieuses à paramétrer.

Le processeur

Le processeur, (ou CPU, Central Processing Unit, « Unité centrale de traitement » en français) est le composant essentiel d'un ordinateur qui interprète les instructions et traite les données d'un programme.

La vitesse de traitement d'un processeur est encore parfois exprimée en MIPS (million d'instructions par seconde) ou en Mégaflops (millions de floating-point operations per second) pour la partie virgule flottante, dite FPU (Floating Point Unit). Pourtant, aujourd'hui, les processeurs sont basés sur différentes architectures et techniques de parallélisation des traitements qui ne permettent plus de déterminer simplement leurs performances. Des programmes spécifiques d'évaluation des performances (benchmarks) ont été mis au point pour obtenir des comparatifs des temps d'exécution de programmes réels.

C'est le processeur qui apporte aux ordinateurs leur capacité fondamentale à être programmés, c'est un des composants nécessaires au fonctionnement de tous les types d'ordinateurs, associés aux mémoires primaires et aux dispositifs d'entrée/sortie. Un processeur construit en un seul circuit intégré est communément nommé microprocesseur, à l'inverse, certains fabricants ont développé des processeurs en tranches, dans ce cas les fonctions élémentaires (ALU, FPU, séquenceur, etc.) sont réparties dans plusieurs circuits intégrés spécialisés.

L'invention du transistor en 1947 a ouvert la voie de la miniaturisation des composants électroniques et le terme d'unité centrale (CPU) est utilisé dans l'industrie électronique dès le début des années 1960 (Weik 1961). Depuis le milieu des années 1970, la complexité et la puissance des microprocesseurs n'a cessé d'augmenter au-delà de tous les autres types de processeurs au point qu'aujourd'hui les termes de processeur, microprocesseur ou CPU, s'utilisent de manière indifférenciée pour tous les types de processeurs.

Les processeurs des débuts étaient conçus spécifiquement pour un ordinateur d'un type donné. Cette méthode coûteuse de conception des processeurs pour une application spécifique a conduit au développement de la production de masse de processeurs qui conviennent pour un ou plusieurs usages. Cette tendance à la standardisation qui débuta dans le domaine des ordinateurs centraux (mainframes à transistors discrets et mini-ordinateurs) a connu une accélération rapide avec l'avènement des circuits intégrés. Les circuits intégrés ont permis la miniaturisation des processeurs dont les dimensions sont réduites à l'ordre de grandeur du millimètre. La miniaturisation et la standardisation des processeurs ont conduit à leur diffusion dans la vie moderne bien au-delà des usages des machines programmables dédiées. On trouve les microprocesseurs modernes partout, de l'automobile aux téléphones portables, en passant par les jouets pour enfants.

La mémoire Ram DDR 2 ,3

La DDR2 SDRAM ou DDR2 (de l'anglais Double Data Rate two Synchronous Dynamic Random Access Memory) est la seconde génération de mémoire vive de type DDR pour les ordinateurs personnels, la première étant la technologie DDR. Ce type de mémoire informatique utilise des circuits intégrés. Cette technologie fait partie de la famille des mémoires vives SDRAM, qui elle-même est une des multiples versions des mémoires DRAM.

Avec une fréquence d'horloge de 100 MHz, une mémoire SDR SDRAM (communément appelée seulement "SDRAM") transfère les données sur le front montant des impulsions d'horloge. Ce qui permet d'atteindre un débit de transfert de données de 0,8 Go/s.

Contrairement à la SDR-SDRAM, la DDR-SDRAM et la DDR2-SDRAM effectuent les transferts sur le front montant et le front descendant des impulsions d'horloge (une technique appelée "dual pumping" en anglais). Le taux de transfert est doublé, il est équivalent à 200 MHz (et une bande passante théorique de 1,6 Go/s) tout en utilisant la même fréquence d'horloge.

La différence majeure entre la DDR et la DDR2 est que la fréquence du bus est maintenant égale au double de celle du groupe de cellules mémoires. Quatre mots de données peuvent ainsi être transférés par cycle des cellules mémoires. À fréquence des cellules mémoires égale, la DDR2 a un débit deux fois plus élevé que celui de la DDR.

La fréquence d'horloge de la mémoire DDR2 est également généralement plus grande grâce à des améliorations techniques au niveau de l'interface électrique, avec des raccordements intégrés, une mémoire tampon de prélecture, ainsi que des circuits de sortie externes à la puce. Cependant, la DDR2 a des temps de latence plus élevés. L'accès aux puces, qui est décomposé en n étapes, est plus long. En ce qui concerne la mémoire tampon de prélecture, sa largeur de bus est passée de 2 bits (pour la DDR) à 4 bits. Elle passera à 8 bits pour la DDR3. En d'autres termes, cette mémoire convient plutôt aux transferts de grandes quantités de données, car la grande vitesse de transfert sur une "longue" période minimise alors le mauvais temps de latence initial.

La DDR2 possède un avantage majeur avec une tension d'alimentation à 1,8 Volt, ce qui limite la production de chaleur par effet joule.

Le DDR3 SDRAM, plus généralement connu sous la forme simplifiée DDR3, est un standard de mémoire vive électronique défini par le JEDEC, destiné à être progressivement utilisé dans les ordinateurs personnels commercialisés à partir de l'année 2007.

DDR3 SDRAM est un acronyme anglais pour Double Data Rate 3rd generation Synchronous Dynamic Random Access Memory, signifiant en français Mémoire à Accès Aléatoire Synchrone à Débit de Données Doublé de troisième génération. Le standard DDR3 a été élaboré dans le but de succéder au standard DDR2, en offrant des améliorations de performances tout en diminuant la consommation électrique.

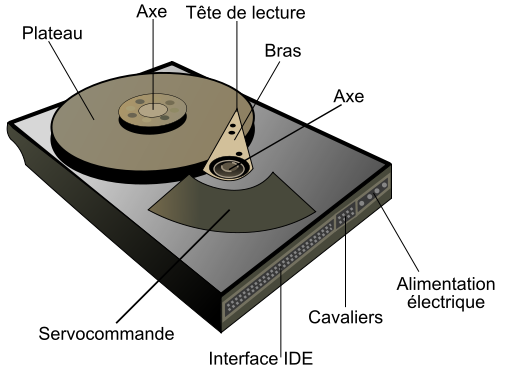

Disque Dur

Un disque dur, en anglais hard drive (HD) ou hard disk drive (HDD), est une mémoire de masse magnétique très utilisée dans les ordinateurs.

Dans un disque dur, on trouve des plateaux rigides en rotation. Chaque plateau est constitué d'un disque réalisé généralement en aluminium, qui a les avantages d'être léger, facilement usinable et non magnétique. Des technologies plus récentes utilisent le verre ou la céramique, qui permettent des états de surface encore meilleurs que ceux de l'aluminium. Les faces de ces plateaux sont recouvertes d'une couche magnétique, sur laquelle sont stockées les données. Ces données sont écrites en code binaire [0,1] sur le disque grâce à une tête de lecture/écriture, petite antenne très proche du matériau magnétique. Suivant le flux électrique qui traverse cette tête, elle modifie le champ magnétique local pour écrire soit un 1, soit un 0, à la surface du disque. Pour lire, c'est le même principe qui est utilisé, mais dans l'autre sens : le champ magnétique local engendre un flux électrique au sein de la tête qui dépend de la valeur précédemment écrite, on peut ainsi lire un 1 ou un 0.

Un disque dur typique contient un axe central autour duquel les plateaux tournent à une vitesse de rotation constante. Les têtes de lecture/écriture sont reliées à une même armature qui se déplace à la surface des plateaux, avec une tête par plateau. L'armature déplace les têtes radialement à travers les plateaux pendant qu'ils tournent, permettant ainsi d'accéder à la totalité de leur surface.

L'électronique associée contrôle le mouvement de l'armature ainsi que la rotation des plateaux, et réalise les lectures et les écritures suivant les requêtes émises par le contrôleur du disque. Les firmwares des disques durs récents sont capables d'organiser les requêtes de manière à minimiser le temps d'accès aux données, et donc à maximiser les performances du disque.

Les disques durs ayant les capacités les plus importantes sur le marché dépassent les 2 To (téra-octets) (2008). La capacité des disques durs a augmenté beaucoup plus vite que leur rapidité, limitée par la mécanique. Le standard 2008 est de 500 Go pour les PC de bureau (à partir de 0,1 € par Go en août 2008) et de 160 Go pour les PC portables. Le standard 1997 était de 2,0 Go pour les disques dur de 3,5 pouces

La Carte graphique

Le processeur graphique (Graphical Processing Unit ou GPU en anglais, voir même Visual Processing Unit ou VPU) sert à libérer le micro-processeur de la carte mère en prenant en charge les calculs spécifiques à l’affichage et la coordination de graphismes 3D ou la conversion YCbCr vers RGB.

Cette division des tâches entre les deux processeurs libère le processeur central de l’ordinateur et en augmente d’autant la puissance.

Le processeur graphique est très souvent muni de son propre radiateur ou ventilateur pour évacuer la chaleur qu’il produit.

Ces 15 dernières années, les cartes graphiques ont fortement évolué. Autrefois, la fonction essentielle d'une carte graphique était de transmettre les images produites par l'ordinateur à l'écran. C'est encore sa fonction principale sur beaucoup de machines à vocation bureautique où l'affichage d'images en 3D n'offre que peu d'intérêt. Toutefois aujourd'hui même les cartes graphiques les plus simples gèrent aussi le rendu d'images en 3D temps réel avec plus ou moins de succès. C'est une activité très coûteuse en termes de calculs et en termes de bande passante mémoire. Le GPU est donc devenu un composant très complexe, très spécialisé et presque imbattable dans sa catégorie (rendu d'images en 3 dimensions). Hormis pour les jeux vidéo ou quelques usages en infographie, les possibilités des cartes graphiques ne sont que très peu exploitées en pratique. Ainsi ce sont essentiellement les joueurs qui achètent et utilisent des GPU de plus en plus puissants.

Depuis quelques années, la puissance de calcul des cartes graphiques est devenue tellement importante pour un coût finalement très réduit (100 à 700€ pour les modèles grand public) que les scientifiques sont de plus en plus nombreux à vouloir en exploiter le potentiel dans d'autres domaines. Il peut s'agir de faire tourner des simulation de modèles météo, financiers ou toute opération parallélisable et nécessitant une très grande quantité de calcul. NVIDIA et ATI (racheté depuis par AMD), les 2 principaux fabricants de cartes graphiques haute performance grand public proposent chacun des solutions propriétaires afin de pouvoir utiliser leur produit pour du calcul scientifique; pour NVIDIA, on pourra se référer au projet CUDA [réf. nécessaire]. On parle à ce titre de General-purpose computing on graphics processing units (ou GPGPU)

Une carte graphique ou carte vidéo (anciennement par abus de langage une carte VGA), ou encore un adaptateur graphique, est une carte d'extension d'ordinateur dont le rôle est de produire une image affichable sur un moniteur d'ordinateur. La carte graphique convertit les données numériques internes à l'ordinateur en un signal électrique numérique ou analogique compatible avec le moniteur.

La mémoire vidéo conserve les données numériques qui doivent être converties en images par le processeur graphique et les images traitées par le processeur graphique avant leur affichage.

Toutes les cartes graphiques supportent deux méthodes d'accès à leur mémoire. L'une est utilisée pour recevoir des informations en provenance du reste du système, l'autre est sollicitée pour l'affichage à l'écran. La première méthode est un accès direct conventionnel (RAM) comme pour les mémoires centrales, la deuxième méthode est généralement un accès séquentiel à la zone de mémoire contenant l’information à afficher à l'écran.

Voir l'article principal : Mémoire vidéo.

On peut retrouver les connexions suivantes selon les cartes graphiques :

Les interfaces analogiques :

- L'interface VGA standard : les cartes graphiques sont la plupart du temps équipées d'un connecteur VGA 15 broches (Mini Sub-D, composé de 3 séries de 5 broches), généralement de couleur bleue, permettant notamment la connexion d'un écran CRT. Ce type d'interface permet d'envoyer à l'écran 3 signaux analogiques correspondant aux composantes rouges, bleues et vertes de l'image.

- L'interface Vidéo composite : Pour la sortie sur un simple téléviseur ou un magnétoscope.

- L'interface S-Vidéo : De plus en plus de cartes sont équipée d'une prise S-Video permettant d'afficher ce signal sur une télévision ou un vidéo projecteur qui le permet.

Cette sortie analogique est souvent livrée avec un adaptateur S-Video => Vidéo composite; c'est la raison pour laquelle elle est souvent appelée prise télé (notée aussi « TV-out »).

Les interfaces numériques :

- L'interface DVI (Digital Video Interface), présente sur certaines cartes graphiques, permet d'envoyer, aux écrans le supportant, des données numériques. Ceci permet d'éviter des conversions numérique-analogique, puis analogique numériques, inutiles.

- Une interface HDMI permettant de relier la carte à un écran haute définition en transmettant également la partie audio (polyvalent, ce format est le remplaçant de la péritel). Le signal est un signal purement numérique.

- Une interface DisplayPort, une interconnexion digitale audio/vidéo de nouvelle génération, sans droit et licence.

Note : le DVI et le HDMI peuvent supporter les DRM.

Les modèles actuels associent généralement deux types d'interface: une interface pour la télévision (S-Vidéo ou HDMI) avec une interface pour écran d'ordinateur (VGA ou DVI).

Graveur

Un graveur de disque optique à diode laser est un appareil électronique dédié au stockage d'information pour l'informatique, l'audio et la vidéo.

Il permet de graver des CD-R et CD-RW (Compact Disc, "R" pour Recordable et "RW" pour ReWritable, soit respectivement disque compact enregistrable et disque compact réinscriptible), des VCD et des SVCD, éventuellement des CD+G, des DVD±R et DVD±RW (Digital Versatile Disc, "R" pour Recordable et "RW" pour ReWritable, soit respectivement disque numérique polyvalent enregistrable et disque numérique polyvalent réinscriptible).

Remarquons que le terme gravure n'est pas approprié. Dans le cas d'enregistrement de CD-R ou de DVD±R, il s'agit de brûlures multiples de la surface du support afin de créer les zones de non-réflexion pour le laser en lecture. Dans le cas de disques réinscriptibles (magnéto-optiques), la zone chauffée par le laser permet à une tête magnétique de modifier sa capacité à réfléchir la lumière.

En informatique [modifier]

Il s'agit soit d'un périphérique interne se trouvant dans l'unité centrale (matériel informatique), soit d'un périphérique externe sur port USB ou FireWire.

Audio et vidéo [modifier]

Peut être présent sur une chaîne Hi-fi, une unité multimédias ou une platine audiovisuelle de salon. On le trouve parfois dans un enregistreur DVD de salon ou "DVDscope" (évolution de Magnétoscope et DVD).

Windows Vista

|

|

|---|---|

| Famille | Microsoft Windows |

| Type de noyau | Noyau hybride |

| Entreprise/ Développeur |

Microsoft |

| Licence | Microsoft |

| États des sources | Source fermée |

| Dernière version stable | 6.0 (Build 6001) (le 18 mars 2008) [+/−] |

| Méthode de mise à jour | Windows Update |

| Site Web | http://www.windowsvista.fr |

Windows Vista est une version de Microsoft Windows, une gamme de systèmes d'exploitation graphiques qui s'utilise autant sur les ordinateurs personnels que professionnels. Avant l'annonce officielle de son nom définitif le 22 juillet 2005, il avait comme nom de code Longhorn.

Son développement s'est achevé le 8 novembre 2006, et il fut disponible pour les grands comptes dès cette date. Le 30 janvier 2007, eut lieu le lancement mondial pour le grand public. Ce nouveau système d'exploitation arrive cinq ans après la mise sur le marché de son prédécesseur, Windows XP.

Selon Microsoft, Windows Vista contiendrait des centaines de nouvelles fonctionnalités. Les plus significatives d'entre elles sont probablement le renouveau de l'interface graphique, une fonction de recherche plus développée grâce à l'indexation, de nouveaux outils de création multimédia, comme le créateur de DVD Windows, la configuration réseau en partie réécrite et, enfin, le noyau NT6 assurant une plus grande stabilité et de meilleures performances. Vista vise à augmenter le niveau de communication entre les machines sur un réseau local en utilisant la technologie du peer-to-peer qui simplifie le partage de fichiers et de médias numériques entre les ordinateurs et les périphériques. Pour les développeurs, Vista introduit la version 3 du .NET Framework qui a pour objectif de faciliter la programmation d'applications avec le traditionnel Windows API.

Le premier objectif, dont le résultat reste à démontrer, de Microsoft avec Vista est d'obtenir une meilleure sécurité pour le système. Une des critiques les plus courantes de Windows XP, et de ses prédécesseurs, était que des vulnérabilités permettant aux malwares et aux virus de pénétrer dans l'ordinateur étaient découvertes, et exploitées, relativement souvent. À la vue de ceci, Bill Gates a annoncé début 2002 le rachat de Trustworthy Computing pour ajouter de nouvelles fonctions de sécurité dans les prochaines versions. Microsoft a déclaré qu'il a donné la priorité à l'amélioration de la sécurité de Windows XP et celle de Windows 2003 Serveur avant de finir le développement de Vista, ce qui a retardé de manière significative sa version finale.

Le développement de Windows Vista a été annoncé en août 2001, comme une version intermédiaire de Windows Seven (Seven car la version 7 de l'OS de Microsoft n'avait pas encore de nom.). Ce dernier ayant un retard important, Microsoft a préféré sortir une version intermédiaire intégrant certaines fonctionnalités de Seven.

A l'heure actuelle, Microsoft expose déjà largement le successeur de Windows Vista (notamment au PDC 2008), censé faire oublier les défauts de ce dernier. Il fut connu au départ sous le nom de code Vienna, pour finalement s'appeler officiellement Windows 7, 'attendu' pour fin 2009/début 2010.

De nombreuses versions de test ont été mises en circulation en interne et se sont retrouvées aux mains du public de manière plus ou moins légale. Ces versions, comportant des bugs pour la plupart (il s'agit de versions de développement), et ressemblaient encore à Windows XP.

À l'origine, Microsoft a annoncé que plusieurs technologies et améliorations ne seraient disponibles que sous Windows Vista, mais finalement Avalon (nom de code de Windows Presentation Foundation) et Indigo, respectivement sous-système graphique et de communications de Vista, seront portés sous Windows XP ; mais, par contre, WinFS, le service de recherche associé au système de fichiers, ne fera pas partie du système mais sera livré plus tard en téléchargement.

Ensuite, Microsoft n'a plus communiqué sur Vista jusqu'au WinHEC d'avril 2005. Pendant ce temps, le développement a été gelé, et les méthodes de développement ont été repensées, avant de reprendre celui-ci, sous le code de Windows NT 5.2, soit Windows Server 2003 Service pack 1. Au WinHEC 2005, la version 6.0.5048 est livrée aux développeurs.

La bêta 1 est arrivée ensuite et a apporté les premières améliorations depuis la remise à plat du processus de développement. Dossiers virtuels (se basant sur des requêtes de recherches), nouvelle interface et comptes réellement limités (comme sous UNIX, de manière à limiter les dégâts causés par une application malveillante ou dysfonctionnelle).

Difficultés de développement

La version finale du système d'exploitation est officiellement sortie le 30 janvier 2007 en version boîte pour les particuliers et était disponible dès le 30 novembre 2006 en version RTM pour les entreprises (version Entreprise).

Son développement aura été aussi long car Microsoft a dû corriger certains points noirs des versions antérieures, comme l'instabilité, le problème de la fragmentation et les failles de sécurité, entre autres.

Vista devait intégrer un nouveau système de fichiers (Win FS) qui était censé être une révolution dans la gestion des fichiers sur un PC. Finalement après quelques apparitions dans les premières versions alpha de Vista (Longhorn), Win FS a été abandonné car il était trop lent et pas du tout prêt.

Un revirement aussi a été fait au niveau du manager du projet Vista qui a été remplacé par le manager des équipes de Microsoft Office. Celui-ci étant connu pour livrer toujours à temps les logiciels dont il était responsable.

Un certain nombre d'éléments qui devaient former un ensemble propre à Windows Vista, comme Avalon (nom de code de Windows Presentation Foundation), le système d’interface utilisateur, Indigo, le système de gestion des connexions réseau, ainsi qu'Internet Explorer 7, Windows Media Player 11 ou Movie Maker 3 sont disponibles séparément pour les utilisateurs de Windows XP.

- mai 2001 : début du développement de version de Windows destinée à succéder à Windows XP pour la fin de l'année 2003 ;

- 12 juin 2002 : Milestone 1 - Build 3646, fondée sur le code de Windows XP ;

- 28 juillet 2002 : Milestone 2 - Build 3663 et premières captures d'écrans présentées au public ;

- 23 septembre 2002 : Milestone 3 - Build 3683, visuellement très proche de Windows XP, mais offrant une barre latérale et incluant une ébauche de WinFS ;

- 20 octobre 2002 : fuite d'une version de développement (build 3683) qui est disponible pour la première fois sur Internet ;

- 19 février 2003 : Milestone 4 - Build 4008, nouveau thème Plex, nouvel installeur, nouvelle barre de tâches et nouvel Internet Explorer ;

- 28 mars 2003 : Milestone 5 - Build 4015, introduction des dossiers virtuels ;

- 25 avril 2004 : Milestone 7 - Build 4074, introduction d'un nouveau thème d'icônes et du thème Jade ;

- 27 août 2004 : Microsoft annonce le report de la sortie du successeur de Windows XP, et que de gros changements allaient avoir lieu sur la version en développement, notamment en se fondant sur le code de Windows 2003 Serveur et en y incorporant seulement les fonctionnalités nécessaires. Des fonctionnalités comme WinFS et NGSCB étant annulées ou reportées à plus tard ;

- 7 septembre 2004 : Longhorn D1 - Build 3790, première version fondée sur le code de Windows 2003 ;

- 1er avril 2005 : Longhorn D1 - Build 5048 ;

- 22 juillet 2005 : Microsoft dévoile le nom officiel de sa future mouture, Windows Vista ;

- 27 juillet 2005 : sortie de la première version Beta 1 - Build 5112, réservé aux bêta-testeurs et aux professionnels, et qui apporte de nombreuses modifications apportées à l'interface et au shell, ainsi que de nouvelles icônes haute résolution, une nouvelle interface à Internet Explorer et le contrôle parental ;

- 21 février 2006 : sortie de la première version dite feature complete aux bêta-testeurs et aux TAP. Interface Aero disponible ;

- 23 mai 2006 : sortie de la version Beta 2 - Build 5384, uniquement réservée aux abonnés MSDN et Microsoft TechNet

- 8 juin 2006 : la Beta 2 est à la disposition de tous ;

- 1er septembre 2006 : sortie de la version RC1 (Release Candidate) - Build 5600, uniquement réservée à un groupe restreint de beta testeurs ;

- 6 septembre 2006 : la version RC1 est accessible aux abonnés Technet et MSDN ;

- 14 septembre 2006 : la version RC1 est disponible pour tout le monde ;

- 6 octobre 2006 : sortie de la version RC2 - Build 5700, uniquement réservée aux beta testeurs ;

- 7 octobre 2006 : la version RC2 est disponible pour tout le monde ;

- 8 novembre 2006 : sortie de la version RTM (Release To Manufacturing = finale) - Build 6000 ;

- 15 novembre 2006 : les abonnés de la communauté de développeurs MSDN, de Technet

Merci, votre note vient d'être comptabilisée.Merci, mais vous avez déjà voté pour cette page, réessayez plus tard.Vous devez être connecté pour pouvoir voter★ ★ ★ ★ ★Aucune note. Soyez le premier à attribuer une note !

Ajouter un commentaire

Commentaires

1 get traffic Le 26/02/2013

Use this BRAND NEW software and get all the traffic for your website you will ever need ...

= = > > http://push-button-traffic.net

In testing phase it generated 867,981 visitors and $540,340.

Then another $86,299.13 in 90 days to be exact. That's $958.88 a

day!!

And all it took was 10 minutes to set up and run.

But how does it work??

You just configure the system, click the mouse button a few

times, activate the software, copy and paste a few links and

you're done!!

Click the link BELOW as you're about to witness a software that

could be a MAJOR turning point to your success.

= = > > http://push-button-traffic.net

2 JACQUES BAGULA II Le 09/01/2013

3 kyleleonmusclemaximizer36 Le 31/10/2012

http://community.babycenter.com/journal/exerciseme1025/5688925/muscle_max_exercise_session_method_timetable_-_techniques_of_your_muscle_max_exercise_session_strategy

4 vellimife Le 25/10/2012

5 marwan Le 26/09/2012

6 Weemamoninsus Le 16/09/2012

7 buya Le 02/08/2012

de la part junior buya.

8 NISSAR Le 01/04/2012

9 kawtarabouayoub Le 25/02/2012

10 toto Le 26/11/2011

11 touil Le 22/08/2011

12 nico-blog Le 27/06/2011

valery claude : Vous avez pas besoin de composant ya des logiciel qui sont la pour sa comme adl tv ou maxtv voilas =)

Merci pour vos Msg :)

13 poiuyt Le 19/04/2011

14 ploum Le 02/12/2010

Il y a un truc qui me fait bien marrer, c'est: "Selon Microsoft, Windows Vista contiendrait des centaines de nouvelles fonctionnalités."

D'une part, je ne vois pas de grande différence avec XP, d'autre part, Micro$oft c'est permis au bout de quelques mois de ne plus assumer la maintenance de ce système instable... Bref, je suis depuis passé sous GNU/Linux (Ubuntu) et je me retrouve avec un système nettement plus performant, stable et mis à jour.

15 yio Le 14/09/2010

16 yio Le 14/09/2010

17 valery claude Le 22/04/2010

18 lloo Le 29/03/2010

19 fonkel Le 19/01/2010

20 merilien samson Le 17/09/2009

Merci

Merilien Samson

21 ali hamza Le 03/07/2009

me"rci d'avance pour la reponse

22 mickael Le 05/05/2009